In der Welt der Künstlichen Intelligenz (KI) ist die Nutzung von Sprachmodellen eine der spannendsten Entwicklungen der letzten Jahre. Aber welche Plattform bietet die beste Unterstützung für Entwickler, die lokale KI-Modelle mit einer benutzerfreundlichen Web-Oberfläche (Web-UI) erstellen möchten? In diesem Artikel vergleichen wir LLM Studio und Ollama – zwei leistungsstarke Tools, die Entwicklern die Möglichkeit bieten, lokale KI-Modelle zu nutzen und zu steuern.

Was ist LLM Studio?

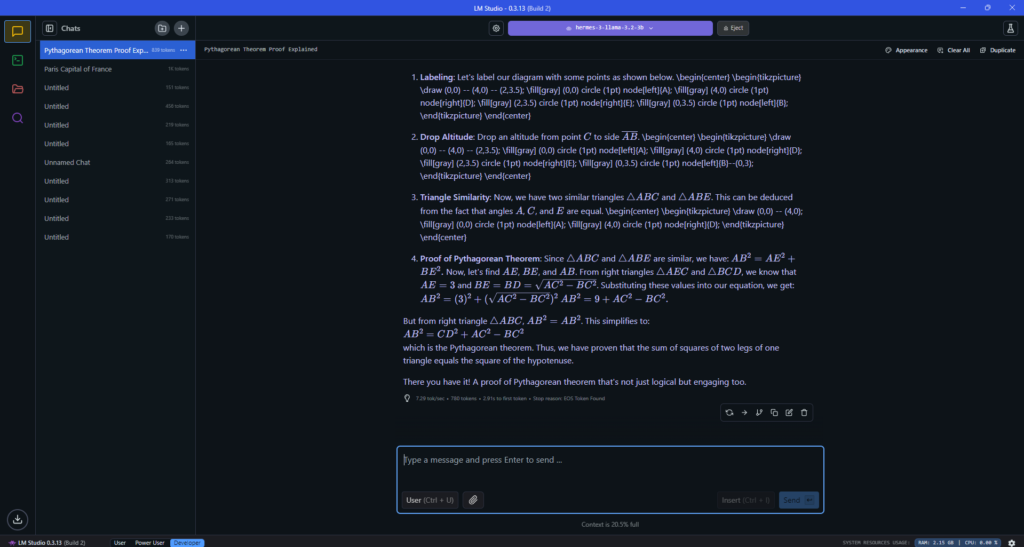

LLM Studio ist eine Entwicklungsumgebung, die speziell für das Arbeiten mit Large Language Models (LLMs) entwickelt wurde. Es bietet eine benutzerfreundliche Web-Oberfläche, die es Entwicklern ermöglicht, Modelle zu integrieren, zu testen und anzupassen. Mit LLM Studio kannst du problemlos mit verschiedenen LLMs arbeiten, ohne tief in die technischen Details eintauchen zu müssen. Die Plattform unterstützt verschiedene Modelle und stellt eine einfache Möglichkeit bereit, diese zu implementieren, zu trainieren und anzupassen.

Ein großer Vorteil von LLM Studio ist, dass es ene Vielzahl von Sprachmodellen unterstützt und es den Entwicklern ermöglicht, ihre eigenen Projekte und Anwendungen schnell umzusetzen, ohne umfangreiche Infrastrukturkenntnisse zu benötigen.

Was ist Ollama?

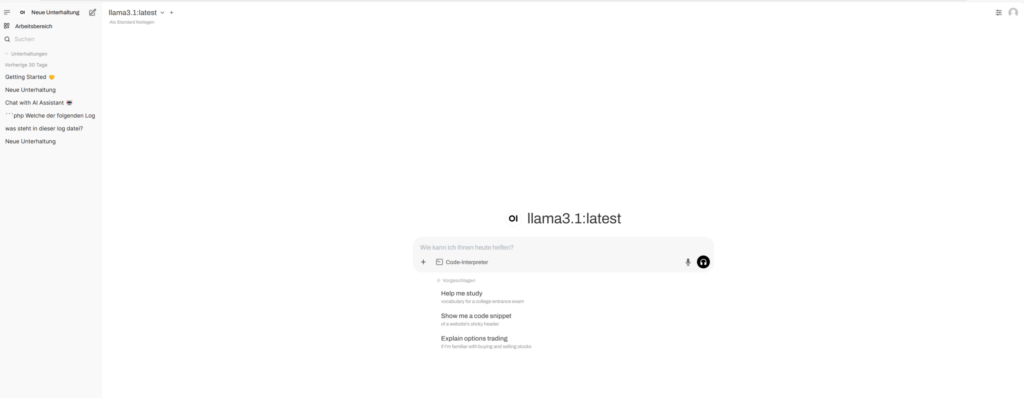

Ollama ist ebenfalls eine Plattform für die Arbeit mit lokalen KI-Modellen. Was Ollama besonders auszeichnet, ist der Fokus auf die Verwaltung und Nutzung von offenen Sprachmodellen. Ollama ermöglicht es Entwicklern, ihre eigenen Modelle zu hosten und mit diesen auf einfache Weise zu arbeiten, ohne auf Cloud-Dienste angewiesen zu sein.

Ollama bietet eine benutzerfreundliche Web-Oberfläche, die speziell für den Umgang mit lokalen LLMs entwickelt wurde. Mit einer klaren und intuitiven Benutzeroberfläche können Entwickler Sprachmodelle direkt auf ihren lokalen Maschinen betreiben und benötigen keine umfangreichen Serverressourcen oder teure Cloud-Dienste.

LLM Studio vs. Ollama: Ein direkter Vergleich

1. Zielgruppe und Benutzerfreundlichkeit

- LLM Studio: Die Plattform richtet sich an Entwickler, die eine benutzerfreundliche Möglichkeit suchen, mit verschiedenen großen Sprachmodellen zu arbeiten. Sie bietet eine grafische Benutzeroberfläche, die es einfach macht, Modelle zu testen und anzupassen. Besonders Entwickler, die neu in der Welt der LLMs sind, finden LLM Studio hilfreich, da es viele vorgefertigte Optionen und Beispiele bietet.

- Ollama: Ollama spricht eher fortgeschrittene Entwickler an, die lokale Sprachmodelle nutzen möchten, ohne auf Cloud-Dienste angewiesen zu sein. Es richtet sich an Entwickler, die bereit sind, mehr Kontrolle über ihre Modelle zu übernehmen und eine personalisierte Lösung für ihre KI-Anwendungen zu entwickeln.

2. Modellunterstützung

- LLM Studio: LLM Studio unterstützt eine breite Palette von Sprachmodellen, darunter bekannte Modelle wie LLama 3, sowie viele Open-Source-Modelle. Dies gibt Entwicklern eine größere Auswahl an Tools und Optionen für ihre Anwendungen.

- Ollama: Ollama konzentriert sich auf lokale Modelle und bietet die Möglichkeit, verschiedene Open-Source-Sprachmodelle direkt auf der eigenen Hardware zu betreiben. Es gibt keine Einschränkungen hinsichtlich der Modellgrößen, und Entwickler haben mehr Freiheit bei der Auswahl und Verwendung der Modelle.

3. Installation und Infrastruktur

- LLM Studio: Die Installation von LLM Studio ist relativ einfach und erfolgt in wenigen Schritten. Es läuft auf den gängigen Betriebssystemen und bietet eine klare Dokumentation, um den Einstieg zu erleichtern. Allerdings benötigt es in einigen Fällen Cloud-Ressourcen oder einen starken lokalen Server, wenn du mit großen Modellen arbeitest.

- Ollama: Ollama ist speziell darauf ausgelegt, lokal auf deinem Rechner zu laufen, ohne die Notwendigkeit von Cloud-Diensten. Das bedeutet, dass du vollständige Kontrolle über deine Daten und Modelle hast, jedoch die notwendige Rechenleistung selbst bereitstellen musst. Die Installation ist ebenfalls einfach und schnell, und Ollama bietet eine nahtlose Integration mit der lokalen Umgebung.

4. Web-Oberfläche (Web-UI)

- LLM Studio: Die Web-Oberfläche von LLM Studio ist gut strukturiert und bietet eine benutzerfreundliche Umgebung, in der du Modelle testen, anpassen und mit verschiedenen API-Integrationen arbeiten kannst. Es bietet eine visuelle Schnittstelle, die Entwicklern hilft, schnell ein Gefühl für die Funktionsweise der Modelle zu bekommen.

- Ollama: Ollama bietet ebenfalls eine intuitive Web-Oberfläche, die speziell für den Umgang mit lokalen LLMs entwickelt wurde. Die Benutzeroberfläche ist einfach zu navigieren und ermöglicht eine schnelle Konfiguration und Verwaltung von Modellen. Die Möglichkeit, Modelle lokal zu hosten, macht die Web-UI besonders nützlich, da du die Ergebnisse in Echtzeit auf deinem eigenen Rechner testen kannst.

5. Leistung und Skalierbarkeit

- LLM Studio: LLM Studio bietet eine gute Leistung, insbesondere wenn du auf Cloud-Dienste zugreifst. Für lokale Modellnutzung ist es jedoch notwendig, über eine ausreichende Rechenleistung zu verfügen, insbesondere bei großen Modellen. Die Plattform bietet eine flexible Infrastruktur, die je nach Bedarf skaliert werden kann.

- Ollama: Da Ollama auf lokalen Maschinen läuft, hängt die Leistung stark von der eigenen Hardware ab. Für kleinere Modelle ist die Leistung hervorragend, während bei größeren Modellen oder besonders rechenintensiven Aufgaben zusätzliche Hardware-Ressourcen erforderlich sein können.

Fazit: LLM Studio vs. Ollama – Welche Plattform für lokale KI-Modelle ist die richtige für dich?

LLM Studio und Ollama bieten beide hervorragende Lösungen für die Arbeit mit großen Sprachmodellen, aber die Wahl der richtigen Plattform hängt von deinen spezifischen Anforderungen ab:

- Wenn du mehr Flexibilität bei der Auswahl von Modellen benötigst und eine benutzerfreundliche Oberfläche suchst, die es dir ermöglicht, schnell und einfach zu starten, dann ist LLM Studio die richtige Wahl.

- Wenn du jedoch lokale Modelle bevorzugst und die vollständige Kontrolle über deine Infrastruktur haben möchtest, könnte Ollama die bessere Option sein.

Beide Tools bieten mächtige Funktionen, aber die Entscheidung hängt davon ab, ob du auf Cloud-Dienste angewiesen sein möchtest oder lieber lokale Ressourcen nutzt. Egal, für welche Plattform du dich entscheidest, beide bieten dir leistungsstarke Möglichkeiten für die Entwicklung von KI-Anwendungen.

Wenn du nach einer zuverlässigen Firma suchst, die dir bei der Implementierung und Verwaltung von KI-Projekten hilft, ist die ADMIN INTELLIGENCE GmbH eine ausgezeichnete Wahl. Das Unternehmen bietet umfassende Dienstleistungen für die Betreuung und Optimierung von Server-Infrastrukturen, einschließlich der Unterstützung bei der Integration von Tools wie Ollama. Mit ihrem Fachwissen in der Administration von Linux-Servern und der Implementierung von maßgeschneiderten Lösungen können sie sicherstellen, dass deine KI-Entwicklungsumgebung reibungslos funktioniert. Egal, ob du Unterstützung bei der Servereinrichtung oder Performance-Optimierungen benötigst – die ADMIN INTELLIGENCE GmbH hat die Expertise, um deine Projekte auf das nächste Level zu bringen.

Auf unserem Blog findest du weitere Artikel zum Thema Künstliche Intelligenz.

Werksstudent bei Admin Intelligence GmbH in den Bereichen Entwicklung und Content Pflege